Cloud Computing, Big Data, Automatisierung und Industrie 4.0

08.07.2013 -

Eine gute Hand bewiesen die Tagungsleiter der "Automation 2013", als sie im Sommer 2012 das Thema für den diesjährigen Kongress am 25. und 26. Juni in Baden Baden festlegten: „Automation (in the) Cloud" war das Motto, das durch die jüngsten Ereignisse um den Datenklau durch amerikanische und britische Geheimdienste besonders kontrovers diskutiert wurde. Müssen wir bei Industrie 4.0 und Cyber Physical Systems eventuell grundlegend umdenken?

Das ideale Rechenzentrum eines Produktionsbetriebs besitzt ausreichend viel, aber nicht zu viel Kapazität - das betrifft Rechenleistung genauso wie Speicherplatz. Aber wie lässt sich das realisieren? Genau so wenig, wie man sein Einfamilienhaus schnell um ein Gästezimmer mit Bad erweitern kann, wenn sich lieber Besuch ansagt, und dieses Zimmer rückstandsfrei wieder abbauen kann nach Abreise des Besuches, lassen sich beim eigenen Rechenzentrum schnell die Kapazitäten erweitern, wenn zum Beispiel ein BigData-Projekt ansteht, um rätselhaften Produktionsschwankungen auf die Spur zu kommen.

Gefragt ist also das „atmende" Haus oder das „elastische" Rechenzentrum. Während man für den ersten Fall auf ein naheliegendes Hotel zurückgreifen kann, bieten sich für den zweiten Fall Dienste aus der Cloud an. Doch während jeder Manager problemlos für sich oder seine Gäste das Hotel nutzen würde, greift noch längst nicht jeder auf die Cloud und die damit vermittelten Dienste zurück.

Cloud-Monitor 2013

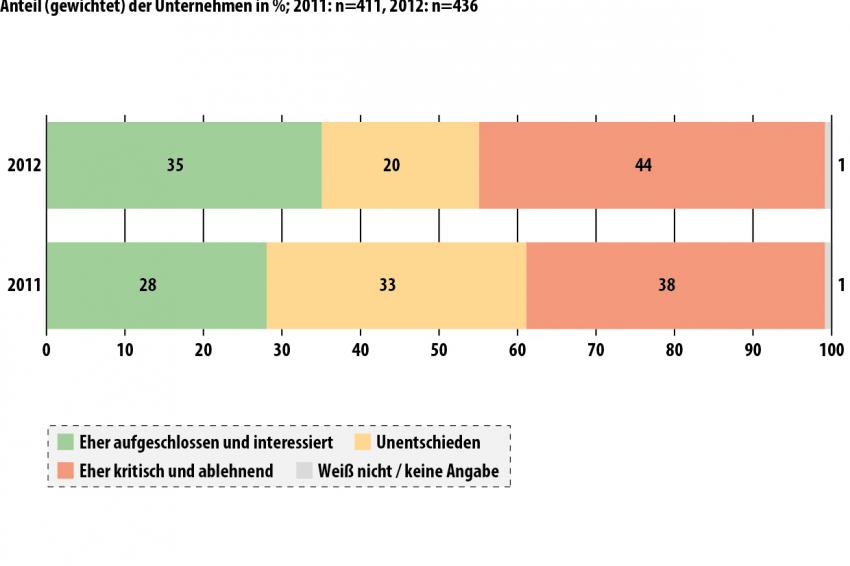

Im Februar 2013 wurde von KPMG in Zusammenarbeit mit Bitcom der "Cloud-Monitor 2013" veröffentlicht, der die faktische Nutzung von Cloud-Computing in deutschen Unternehmen zum Erhebungszeitpunkt abbildet. Die Untersuchung bestätigt, dass immer mehr Unternehmen auf Cloud-Computing setzen und der Cloud aufgrund positiver Erfahrungen zunehmend aufgeschlossen gegenüber stehen. Gleichzeitig ist aber auch die Zahl der Cloud-Skeptiker gewachsen. Die Cloud polarisiert also, was KPMF und Bitcom als einen weiteren Schritt im Reifegrad interpretieren.

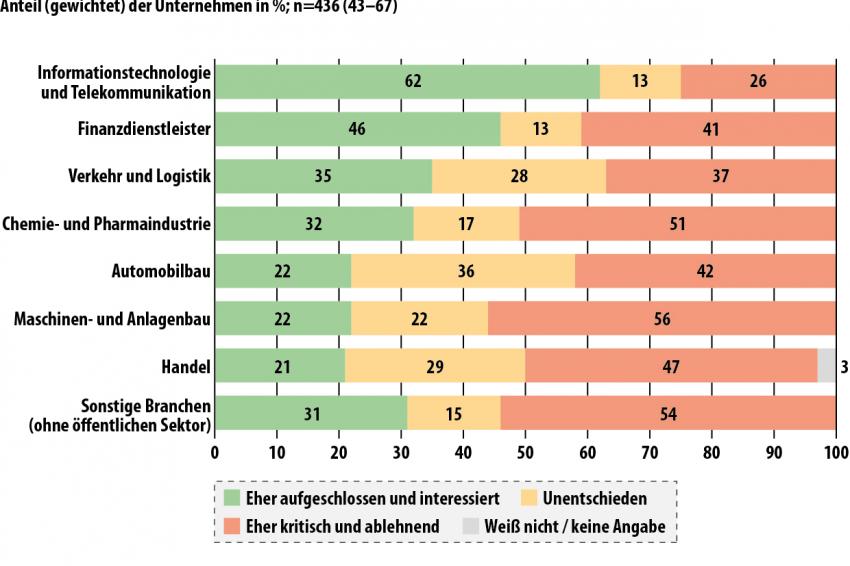

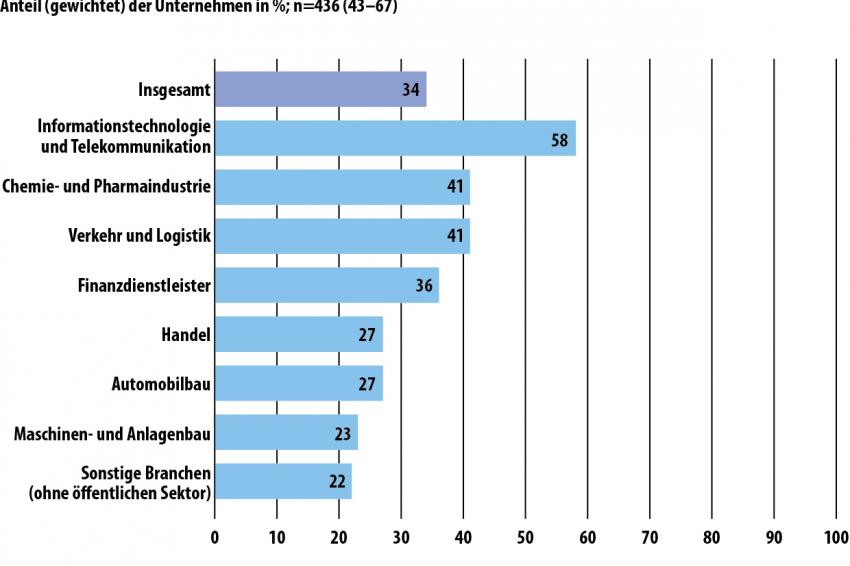

34% der befragten Unternehmen gaben an, die Private Cloud zu nutzen, und 83% der Nutzer haben positive Erfahrungen gesammelt. Insbesondere große und mittlere Unternehmen setzen verstärkt auf diese Technologie. Vorreiter sind die ITK-Branche sowie Finanzdienstleister, aber Chemie und Pharma holen auf. Derzeit werden Private Clouds von deutschen Unternehmen vorwiegend in Eigenregie als interne Private Cloud betrieben. Weniger der Outsourcing-Gedanke steht im Vordergrund als vielmehr eine Neuausrichtung der internen IT-Architektur. 83% der Nutzer haben positive Erfahrungen gesammelt. Die Zahlen für Nutzung und Zufriedenheit haben eine deutlich steigende Tendenz gegenüber dem Vorjahr.

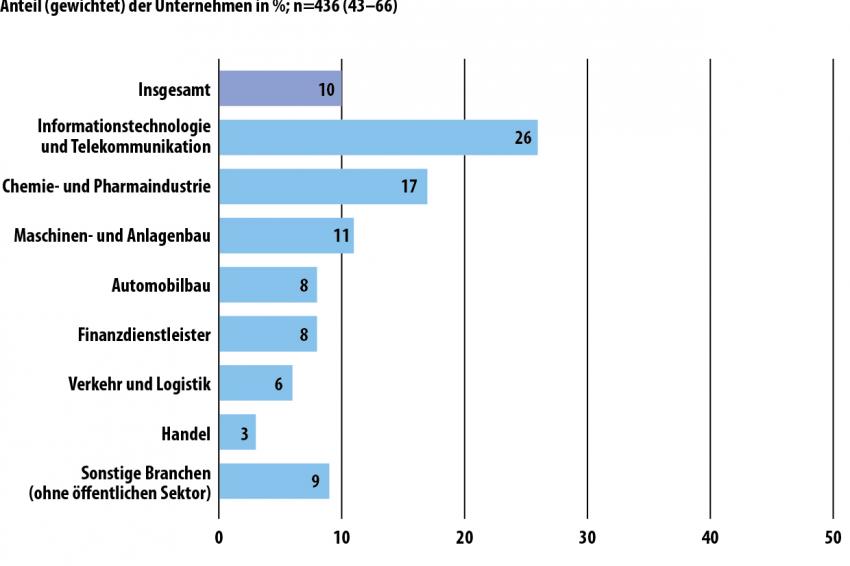

Weniger gut sehen die Zahlen für die Public Cloud aus: Nur 10% der Unternehmen nutzen sie, und der Zufriedenheitsgrad der Nutzer ging innerhalb eines Jahres von 81% auf 74% zurück. Public Cloud-Computing führt in Deutschland noch immer ein Nischendasein. Vor allem kleinere Unternehmen sind hier noch sehr zurückhaltend, obwohl viele Public Cloud-Dienste gerade diese Unternehmen im Fokus haben. Als Hürden für die Nutzung erweisen sich Angst vor Datenverlust und Probleme bei der Integration, etwa durch mangelnde Kompatibilität von Public Cloud-Lösungen.

Automation (in the) Cloud

Das Internet der Dinge, Cyber Physical Systems (CPS), Cloud Computing, zunehmende Vernetzung und natürlich das Projekt „Industrie 4.0" prägen derzeit die Diskussionen der Automatisierer. Die Cloud wird die Automation verändern. Dies war für die VDI/VDE-Gesellschaft Mess- und Automatisierungstechnik (GMA) Anlass, rechtzeitig zum Kongress Automation 2013 ihre Mitglieder zum Thema „Automation (in the) cloud" zu befragen und die Meinungen zur aktuellen Nutzung, zu den Erwartungen und zu den Erfahrungen mit der Cloud einzuholen.

Danach liegt der größte Nutzen der Cloud für die Automation in der zentralen Datenhaltung. Über 60 %der Befragten geben dies an, gefolgt von der Effizienz bei der Nutzung von Speicher- und Rechenkapazitäten sowie der einfacheren Wartbarkeit von Software. Eine höhere Zuverlässigkeit in der Automation wird mit der Cloud eher nicht erwartet. Eine Kostenverringerung sehen nur die Befragten, die in Betrieb und Produktion tätig sind - alle anderen Umfrageteilnehmer nicht. Diejenigen, die die Cloud heute beruflich nutzen, erwarten am ehesten, dass zukünftig Störungen mithilfe der Cloud besser ausgewertet werden können.

Die erwarteten Dienstleistungen aus der Cloud sind das Management von Software-Updates, gefolgt von Störungsauswertung, Diagnose und Dokumentation. Funktionalitäten in den Komponenten der Automatisierungstechnik werden zunehmend über Software implementiert. Software-Updates stehen seit langem regelmäßig auf der Tagesordnung der Anwender. Die Cloud kann hier für Effizienz und Transparenz sorgen. Schon heute werden hierfür Cloud-Dienste über das Internet genutzt.

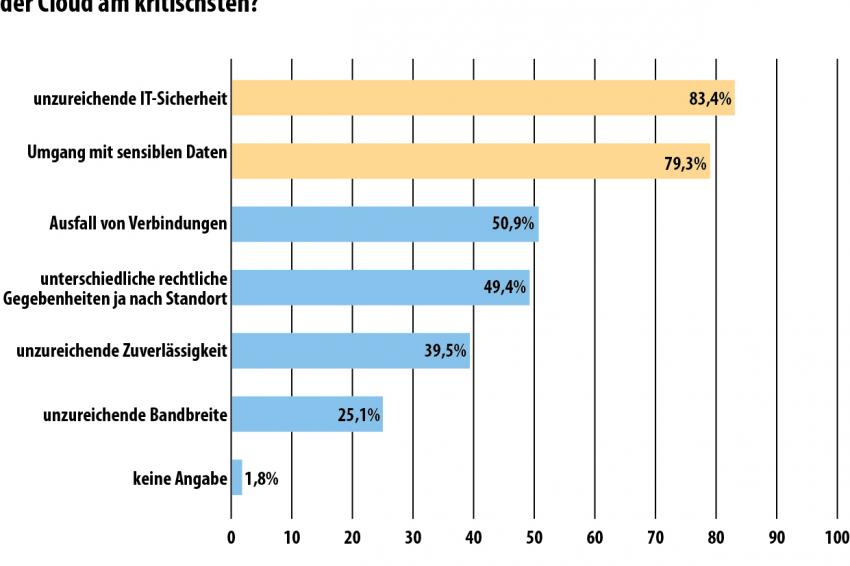

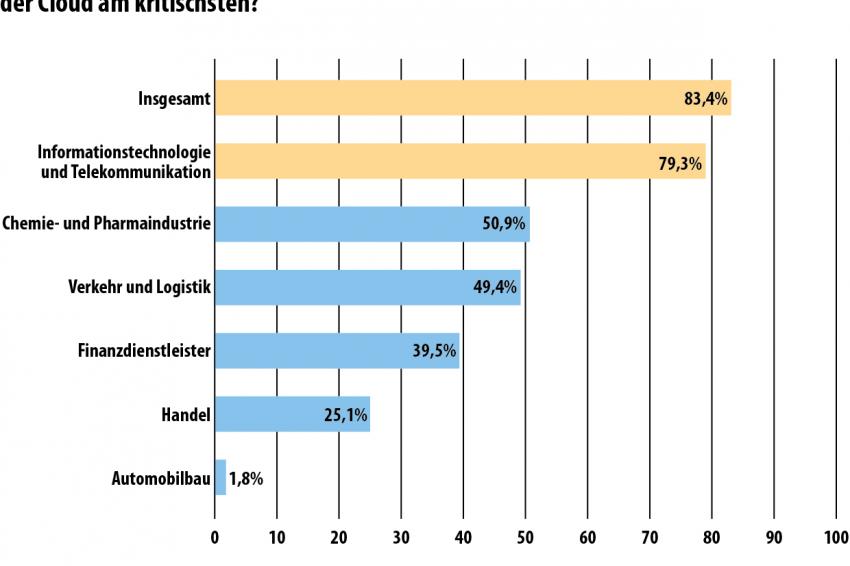

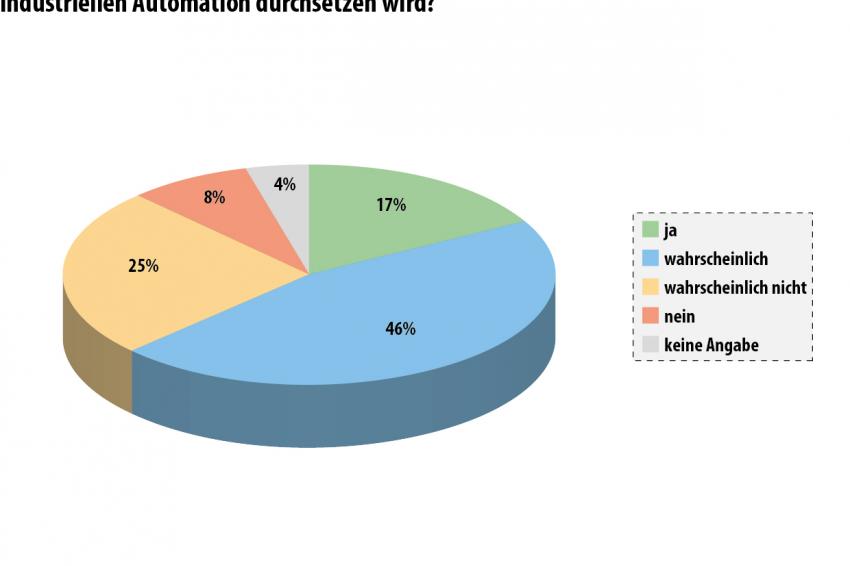

Längst ist bekannt, dass das Cloud Computing auch Risiken birgt. Auf die Frage, welche Aspekte für eine umfangreiche Nutzung der Cloud am kritischsten gesehen werden, wurden mit Abstand am häufigsten die unzureichende IT-Sicherheit und der Umgang mit sensiblen Daten genannt - und dies im Mai 2013! Fast zwei Drittel der Befragten glauben an den Erfolg der Cloud in der industriellen Automation. Nur etwa 8 Prozent sind der Auffassung, dass sich die Cloud auf keinen Fall durchsetzen wird. Es wird mit dem Einzug der Cloud aber noch etwas dauern - ob in 5 Jahren oder noch später sei dahingestellt.

Dr.-Ing. Kurt D. Bettenhausen, Vorsitzender der VDI/VDE-Gesellschaft Mess- und Automatisierungstechnik (GMA), der die Studie auf der Automation 2013 vorstellte, konnte abschließend zusammenfassen: „Die Cloud wird in der Automation heute noch nicht nennenswert genutzt., obwohl die bisherigen Erfahrungen überwiegend gut sind. Die IT-Sicherheit ist der erfolgskritischste Faktor für die Nutzung der Cloud in der Automation. Die Cloud wird in der Automation in etwa 5 Jahren als selbstverständlich genutzt werden."

Industrie 4.0 und die Cloud

Nach Ansicht von Prof. Dr.-Ing. Detlef Zühlke, dem wissenschaftlichen Direktor Innovative Fabriksysteme am DFKI Kaiserslautern, ist das Funktionieren der Cloud in der Automation eine Voraussetzung für das Projekt Industrie 4.0. Er zeigt sich davon überzeugt, dass es mit den Fortschritten in den Bereichen der eingebettete Systeme, der Kommunikationstechnologien, der offenen Plattformen und der Internetdienste große Veränderungen in der industriellen Produktion geben wird. Beginnend bei der digitalen Veredelung technischer Geräte durch dezentrale Intelligenz und durch deren Vernetzung und Aggregation ergeben sich weitgehend selbstkonfigurierende Produktionssysteme.

Dies führt zur Ablösung der heute vorherrschenden horizontalen und hierarchischen Steuerungsarchitekturen durch stärkere vertikale Integration und Durchgängigkeit in Netzwerkstrukturen. Mit dem Speichern und Zugreifen auf Produktions- und Produktdaten über cloudbasierte Architekturen sieht Zühlke eine stärkere Unterstützung des Nutzers.

Die Anlagen werden komplexer und damit wird die Informationsmenge, die wir nutzen können, deutlich ansteigen. Es wird darauf ankommen, diese Informationen für den Menschen so aufzubereiten, dass er sie sinnvoll und einfach nutzen kann und sichere Entscheidungen darauf aufbauen kann. Dies wird ein großes Arbeitsgebiet für die Automation. So sehen es auch die Mitglieder der GMA, die in ihrer Mitgliederumfrage vom Herbst 2012 die Mensch-Maschine-Kommunikation als zweiwichtigstes Erfordernis der Automation sehen.

Von Cloud Computing zu Elastic Computing

Um Leistungen wie Speicherplatz oder Rechenkapazität variabel und anforderungsgerecht anzubieten, müssen neue Wege eingeschlagen werden. Der Plenarvortrag von Prof. Dr. Schahram Dustdar von der Distributed Systems Group der TU Wien auf der Automation 2013 befasste sich mit der Elastizität von Cloud-basierten Systemen bezüglich benötigter Leistung. Das kann nur durch Modellierung der drei beteiligten Ressourcen Software-Dienste, Menschen und Dinge erreicht werden kann.

Ziele sind zum Beispiel nutzungsbasierte Abrechnungen und Vermeidung von Leerkosten. Beim Weg dahin müssen aber gedankliche Barrieren beseitigt werden: „Das Alte ist nicht immer ein gutes Modell für das Neue, das Kleine nicht für das Große, das Einfache für das Komplexe. Um etwas größer und besser als alles Existierende zu machen, muss man über die existierenden Erfahrungen hinausgehen." Ganz aktuelle Erfahrungen über den Umgang mit Daten prägten dann aber die Diskussionen auf den Gängen des Kongresses.

30 Jahre nach 1984

Im Jahr 1948 vollendete George Orwell seinen Roman „1984", in dem er die Schreckensvision eines totalen Überwachungsstaates beschreibt. Was bei der Veröffentlichung des Buches absolut visionär und auch beim gewählten Datum 1984 noch nicht recht vorstellbar war, ist heute offensichtlich kein Problem mehr: Das Internet macht es möglich. Seit einigen Tagen wissen wir genauer, dass das, wer wann was darf und wer was wann macht, sehr fließend interpretiert wird. Die US-amerikanische National Security Agency (NSA) hat bei ihrem Projekt PRISM offensichtlich direkten Zugang zur Internetkommunikation von Anbietern wie Microsoft, Google, Yahoo, Facebook, AOL und Apple. Deren Kollegen vom britischen Geheimdienst Government Communications Headquarters (GCHQ) zapfen derweil beim Projekt Tempora munter die Übertragungskabel an, die die Internetknotenpunkte in Europa und Übersee verbinden.

Im Rahmen dieser Aktivitäten ist die massive Spionage gegen Deutschland ein besonderer Schwerpunkt. Dieser umfassende Big-Data-Angriff bedeutet eine Zäsur für den Wirtschaftsstandort Deutschland, für das Bemühen von Industrie und Regierung, die informationstechnische Integration der Infrastruktur Deutschlands voran zu bringen. Die bisherigen Bedrohungsszenarios für Smart Grids, Smart Homes und Industrie 4.0 müssen neu überdacht werden: Man hat den „Großen Bruder" statt den einsamen Hacker einzukalkulieren. Kann man Industrie 4.0, CPS und Cloud Computing gegen Ausforschung absichern, die mit unbegrenzten staatlichen Ressourcen agiert? Sicher ist: Neben Industrie 4.0 muss Security 4.0 gleichrangig Bedeutung finden.

Von Freunden und Feinden

„Die bekannt gewordenen massiven Spionageaktivitäten durch amerikanische und britische Geheimdienste haben unsere Vermutungen bestätigt, dass man auch vor der Bespitzelung befreundeter Staaten nicht sicher sein kann", erklärte Rainer Glatz, Geschäftsführer der VDMA-Arbeitsgemeinschaft Produkt- und Know-how-Schutz. Der Verlust von elementarem Know-how um Prozesse, Produkte, Märkte und Kunden bedroht die deutsche Industrie. Neben der existentiellen Bedeutung für jeden Unternehmer ist die deutsche Wirtschaft in Gänze betroffen; der geschätzte Schaden liegt laut Bundesamt für Verfassungsschutz bei ca. 30-60 Mrd. € pro Jahr - Tendenz steigend.

Eine VDMA-Umfrage zum Status quo des Produkt- und Know-how-Schutzes, an der Anfang des Jahres knapp 200 Mitgliedsunternehmen teilgenommen haben, machte deutlich, „dass die vorhandenen Ansätze zum Know-how-Schutz nicht den wachsenden Bedrohungen und Anforderungen entsprechen", so Glatz. „Bereits knapp ein Viertel der befragten Unternehmen schätzt bei Know-how-Diebstahl den Schaden auf mehr als 1 Mio. € je Vorfall, knapp die Hälfte der Befragten sehen Know-how-Schutz als überlebenswichtig für ihr Unternehmen an. Die Bedrohung durch Wirtschaftsspionage wurde mit 32 Prozent noch nicht so hoch bewertet", berichtet Glatz. Wesentlich kritischer wurden Bedrohungen durch Ex-Mitarbeiter (74%) oder direkte Wettbewerber (78%) eingestuft. „Diese Einschätzung dürfte sich vor der aktuellen Diskussion sicherlich massiv verändern", erklärte Glatz.

Hatte sich vor etwa einem Jahr Heinz-Paul Bonn, damals Bitkom-Vizepräsident, im CHEManager-Interview zur Cyber-Security so geäußert: „Ich wäre nicht überrascht, wenn eine Studie ergeben würde, dass Cloud-Services besser vor Angriffen geschützt sind als die klassische mittelständische IT", so muss diese Aussage heute zumindest bezüglich geheimdienstlicher Aktivitäten modifiziert werden. Nach wie vor zutreffend ist aber wohl der Aspekt der Verfügbarkeit: „Die Hochverfügbarkeitsstandards der Cloud-Anbieter gehen in der Regel über das hinaus, was in der Unternehmens-IT unter Wahrung der Wirtschaftlichkeit geleistet werden kann."

Industrie 4.0- quo vadis?

Industrie 4.0 wird kommen, allerdings nur über einen längeren Zeitraum und als Summe von Einzellösungen für jeweils bestimmte Applikationen - das war die Meinung vieler Experten auf dem Kongress Automation 2013 im Juni 2013 in Baden-Baden. Ob und wie die jüngsten Erkenntnisse um PRISM und Tempora die Weiterentwicklung beeinflussen oder vielleicht auch in neue Bahnen lenken, wird zu beobachten sein.