Von der Prozessoptimierung zur Digitalen Transformation

GE Digital wird Sponsor der NAMUR HV 2017

Die 79. NAMUR-Hauptsitzung im November 2016 hat Lösungen zur Optimierung in der globalen Prozessindustrie und insbesondere die Beiträge, die die Automatisierungstechnik dazu leisten kann, aufgezeigt. Für Unternehmen wird es unverzichtbar, ihre Prozesse und Abläufe global zu steuern und zu optimieren – zum Beispiel durch die Integration unterschiedlicher Geschäftsvorgänge, die Expansion in Wachstumsmärkte und die Erweiterung der bestehenden Wertschöpfungsketten über regionale Grenzen und Branchen hinweg. Darüber hinaus sind mehr Effizienz und Flexibilität der Produktionsbetriebe notwendig, um die steigenden Kundenanforderungen, z.B. nach zunehmend spezifizierten Produkten, zu erfüllen.

Anforderungen bleiben – Grenzen lösen sich auf

„A well-managed plant looks silent and boring“ – mit diesem Zitat von Peter Drucker starteten die Redner von Yokogawa, dem Sponsor der vergangenen Hauptsitzung, ihre Präsentation, in der sie die Entwicklung der Prozessautomation zum heutigen Stand aufrissen und einen Blick in die Zukunft warfen.

Bestimmten zu Beginn der industriellen Chemie noch handwerkliche Fähigkeiten die Produktion, so ließen im 20. Jahrhundert das wachsende Prozesswissen und die Möglichkeiten der Automatisierung die Prozessanlagen in bis dahin ungeahnte Größenordnungen wachsen. Riesige Konti-Verbundanlagen der Petro- und Basischemie entstanden, die ganz neue Maßstäbe für Produktivität setzten, aber auch eine wachsende Komplexität mit sich brachten. Die grundlegenden Anforderungen aber sind über alle Entwicklungsschritte hinweg geblieben: Die Produktion muss sicher, zuverlässig und effizient sein und das Bedienpersonal muss die ihm anvertrauten Prozesse verstehen, beherrschen und bestmöglich steuern. Um dies zu gewährleisten, sind neben einer hoch entwickelten Verfahrenstechnik immer leistungsfähigere Sensoren und Aktoren, Elektrik und Elektronik, Informationstechnik und Kommunikationsnetzwerke unverzichtbar. „Künftig werden rein softwarebasierte Lösungen weiter an Bedeutung gewinnen“ gab sich Dr. Andreas Helget, Geschäftsführer von Yokogawa Deutschland, überzeugt.

Beispielhaft für die fortschreitende Digitalisierung zeigte Helget die Entwicklung des Yokogawa-Leitsystems Centum auf, das über Jahrzehnte hinweg vollständig abwärtskompatibel ist und damit Investitionssicherheit für den Betreiber bietet, das skalierbar ist von wenigen Hundert bis zu einer Million TAGS ist, und das Informationstransparenz über die vollständig integrierte sicherheitsgerichtete Steuerung bietet.

Bei aller Kontinuität gibt es aber auch gravierende Änderungen. Fortschreitende Automatisierung hat neue Potenziale erschlossen wie Plant Asset Management oder Advanced Process Control. Und die Entwicklung geht weiter, so Helget: „Die Integration von Daten über Betriebe, Standorte, Unternehmen und Wertschöpfungsketten hinweg wird noch mehr Flexibilität und Effizienz erschließen.“ Das Zusammenrücken von Kundenwünschen und Produktionsanforderungen wird in den Konzepten von Industrie 4.0 weiteren Mehrwert generieren. Helget dazu: „Wenn immer mehr Daten in immer komplexeren Netzwerken verarbeitet werden, dann stößt die klassische Automatisierungspyramide an ihre Grenzen. Um Industrie 4.0 in der Prozessindustrie zu verwirklichen, benötigen wir offene und flexible, modular aufgebaute Strukturen, ohne Abstriche bei der Sicherheit zu machen“.

Big Data – Smart Data

Durchgängige Datenkonzepte erlauben es, sowohl Teilprozesse als auch die Prozessführung als Ganzes zu erfassen, zu überwachen und zu optimieren. Wie aus Prozessdaten Prozesswissen gewonnen werden kann und die Anlageneffizient enorm gesteigert werden kann, zeigte Helget am Beispiel eines realen Prozesses auf: Ein spezieller Polymerisationsprozess eines japanischen Produzenten tendierte dazu, den normalen Reaktionspfad zu verlassen, was zu einem Shut-Down führt. Frühe Anzeichen sind aus den elementaren Messwerten nur schwer auszumachen. Mit Hilfe von Process Data Analytics konnten die Qualitäts- und Produktivitätsrückgänge in einer frühen Phase des Herstellungsprozesses analysiert und vermieden werden.

Process Data Analytics verwendet die Mahalanobis-Taguchi-Methode, eine Mustererkennungsmethode, die in der multivarianten Analyse eingesetzt wird. Die Software führt einen Vergleich der erfassten Daten durch und erkennt jede noch so kleine Abweichung von den Normalbedingungen.

Die Effektivität solcher Datenanalysen hängt stark von den Fachkenntnissen und Kompetenzen der Mitarbeiter am jeweiligen Produktionsstandort und den eingesetzten Instrumenten ab. Als Antwort auf diese Herausforderungen bietet Yokogawa seinen Kunden die Prozessdatenanalyse als Dienstleistung an. Bisher wurden mit japanischen Unternehmen aus der chemischen Industrie und anderen Industriezweigen über 100 Verträge über diesen Service geschlossen. Für diese Unternehmen ist diese Lösung mittlerweile zu einem unverzichtbaren Bestandteil ihrer Qualitätssicherung geworden. Helget dazu: „Mit dem Einsatz solcher Softwarelösungen, aber auch mit dem Einsatz von mehr und/oder besserer Sensorik sind wir nur einen Schritt entfernt von der intelligenten, sich selbst steuernden und optimierenden Anlage“.

NOA – NAMUR Open Architecture

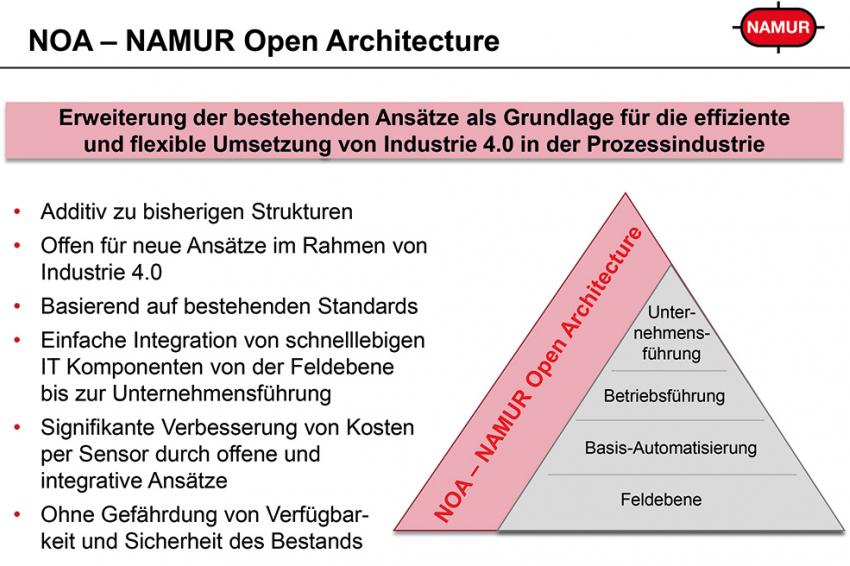

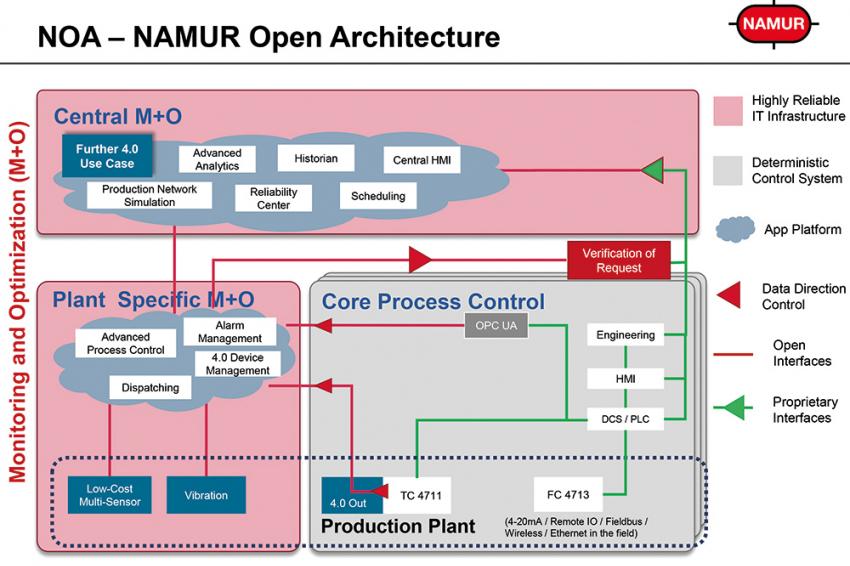

Außerhalb der Automatisierungswelt findet eine rasante Entwicklung im Bereich der Sensorik und der Kommunikationstechniken statt. Dieser Entwicklung ist die durch die klassische NAMUR-Pyramide beschriebene Automatisierungsstruktur, die bewährt und allgemein anerkannt ist und hoch verfügbare, langjährige Betriebssicherheit ermöglicht, nicht mehr gewachsen. Wie kann man die bestehenden Automatisierungsstrukturen so öffnen und ergänzen, dass diese Innovationen nutzbar werden, ohne die Vorteile der bisherigen Automatisierung zu verlieren? Dieser Frage gingen Christian Klettner, BASF und Dr. Thomas Tauchnitz, Sanofi Deutschland, in ihrem Vortrag nach, in dem sie die Entwicklung von NOA – NAMUR Open Architecture durch den NAMUR-Arbeitskreis 2.8 „Automatisierungsnetzwerke und –dienste“ vorstellten. Ziel von NOA ist es, die Nutzung innovativer Technologien zu ermöglichen, um die Wirtschaftlichkeit der Anlagen zu erhöhen. Viele Methoden für Monitoring und Optimierung scheiterten bisher am hohen Aufwand der Implementierung in der Kern-Automatisierung – das kann jetzt überwunden werden.

Im Wesentlichen unterscheidet NOA zwischen der Kern-Automatisierung und einer offenen Systemwelt für Monitoring- und Optimierungsaufgaben. Die Daten der bisherigen Kern-Automatisierungswelt werden durch offene Schnittstellen wie beispielsweise OPC-UA in die Systemwelt für Monitoring- und Optimierungsaufgaben exportiert. Wo erforderlich, können sie aber auch durch einen zweiten Kommunikationskanal direkt an den bestehenden Feldgeräten abgeholt werden. Zusätzliche Sensoren im Bereich Monitoring- und Optimierung können durch NOA einfach in die offene Systemwelt integriert werden. Durch geeignete Methoden und entsprechende Security-Maßnahmen ist sicherzustellen, dass die Funktion aus dem Monitoring und Optimierungsbereich die Kern-Automatisierung nicht beeinträchtigen. Die Daten können entweder in anlagenspezifischen oder zentralen Systemen zum Monitoring oder zur Optimierung ausgewertet werden. Hier sind Funktionen wie Advanced Process Control, Alarm Management, Reliability Center, Dispatching oder andere Level-3-Funktionen auf hoch verfügbarer, aber nicht zwingend echtzeitfähiger IT-Infrastruktur zu finden. Wenn diese Systeme die Kern-Automatisierung z.B. durch eine Befehlsanforderung beeinflussen wollen, muss diese Anforderung durch eine neue Funktion „Verification of Request“ geprüft und freigegeben werden. Diese Prüfung kann durch erlaubte Wertebereiche, Plausibilitätschecks oder auch durch einen Dialog mit dem Operator erfolgen. Durch diese Security-Maßnahme ist sichergestellt, dass die Kern-Automatisierungstechnik nicht durch ungewollte Manipulation von außen beeinträchtigt wird.

Remote Operation für die Produktion von morgen

Bei der Vielfalt von Anlagen, Verfahren und Betriebsmodellen in der Prozessindustrie ist eine allgemein gültige Definition für Remote Operation nicht praktikabel. Zu allgemein anerkannten Zielen zählen ein zentralisierter Betrieb verteilter Anlagen und ein autonomer Betrieb mittels Automatisierung. Remote Operation steht daher für eine Vielzahl an Soll- sowie Übergangszuständen mit inhärentem wirtschaftlichem Nutzen. Der tatsächliche Grad der wirtschaftlichen Machbarkeit dieser Aspekte muss sorgfältig und von Fall zu Fall abgewogen werden. Michael Krauss, BASF, und John Hofland, Shell, zeigten das Potenzial von Remote Operation auf, um den großen Herausforderungen wie der Produktivitätssteigerung, der Flexibilisierung von Produktions- und Businessprozesse, dem demographischen Wandel und der Expertenverfügbarkeit in Wachstumsmärkten zu begegnen. Dabei müssen neben den rein technologischen Gesichtspunkten auch politische, rechtliche und gesellschaftliche Aspekte berücksichtigt werden. Für einen nachhaltigen Erfolg sind bereits in der Designphase neuer Ansätze Veränderungen in Organisation und Anlage zu berücksichtigen.

Data Mining in der Prozessindustrie

Manufacturing Intelligence (MI) stellt einen Bezug zwischen automatisierungstechnischen und betriebswirtschaftlichen Daten her. Durch Etablierung kontinuierlicher Datenströme sollen KPIs der Produktion ermittelt und mit betriebswirtschaftlichen Parametern der Planungsebene verknüpft werden, um eine zeitnahe Analyse der Produktionsprozesse und deren geeignete Beeinflussung zu ermöglichen. MI soll also die richtigen Informationen zur richtigen Zeit den richtigen Personen zur Verfügung stellen, so dass diese ihre Handlungen zielgerichtet optimieren können. Thorsten Pötter, Bayer, zeigte an konkreten Ideen und Beispielen, was heute schon geht und wo es noch – mit besonderem Blick auf die Prozessindustrie - erstaunlichen Entwicklungsbedarf gibt.

Ein Unternehmen, das die digitale Transformation schon selbst intensiv angegangen ist und das anderen Firmen mit Services, Technologien und Ressourcen bei der Digitalisierung unterstützt, ist GE Digital. Mit Predix bietet GE Digital eine Cloud-basierte PaaS (Platform as a Service) an, um industrielle Analysen für Asset Performance Management (APM) durchzuführen und Anlagenoptimierungen zu erreichen. GEs APM-Lösungen sind Anlagen- und Industrieübergreifend einsetzbar und unterstützen jede Art von Betriebsmitteln unabhängig vom Hersteller. Die Anwendung kann sowohl vor Ort installiert werden als auch als „Predix powered“ Cloud basierte Lösung verwendet werden. Die Lösungen decken das gesamte Anforderungsspektrum einer APM-Anwendung ab: Machine & Equipment Health, Reliability Management und Maintenance Optimization.

Für übergreifende Cloud-Anwendungen kooperiert GE mit Microsoft, das Predix auf seinen Azure-Cloud-Services zur Verfügung stellen wird, als auch mit SAP. Die Firmen streben eine Integration zwischen Predix und der HANA-Cloud-Plattform an.

Pötters Resümee: Die Bedeutung der Informations- und Kommunikationstechnologie wächst rasant und ermöglicht Problemlösungen, die in der Vergangenheit unmöglich oder unwirtschaftlich waren. Manufacturing Intelligence macht aus Daten Informationen und ist der Schlüssel zum Erfolg. Und der konsequente Schritt: GE Digital wird Sponsor der NAMUR Hauptversammlung 2017, die am 9. und 10. November in Bad Neuenahr stattfinden wird.

Kontakt

NAMUR - Interessengemeinschaft Automatisierungstechnik der Prozessindustrie e.V.

c/o Bayer AG

51368 Leverkusen

Deutschland

+49 214 30 71034

+49 214 30 96 71034